Performance em Magento 2 (B2B) com IA: otimização, caching e CDN para escalar — e reduzir integrações de 80h para 20–30h | Pentagrama

Magento 2 performance, otimização, caching, CDN: se esses quatro termos parecem um “checklist”, no B2B eles viram requisito de operação. Quando a loja atende representantes, compradores recorrentes e contratos com tabelas de preço complexas, cada milissegundo de atraso vira fricção no funil.E fricção no B2B não gera só abandono de carrinho: muitas vezes vira pedido migrando para WhatsApp, e-mail — ou para o concorrente.

A boa notícia é que performance em Magento 2 não é um mistério. Ela é o resultado direto de métricas bem escolhidas, cache desenhado para personalização B2B, CDN no lugar certo, front-end disciplinado e infra ajustada para concorrência.

A má notícia é que otimizar “no escuro” quase sempre cria regressões — especialmente quando integrações (ERP/PIM/WMS/CRM) entram no checkout, no cálculo de preço ou na validação de estoque.

Neste guia, você vai:

- montar um diagnóstico que se sustenta (baseline + métricas);

- definir budgets por página;

- elevar cache hit rate sem quebrar segmentação;

- usar CDN de forma segura;

- reduzir Core Web Vitals;

- desenhar integrações assíncronas para proteger o checkout.

Ao final, você também verá como a Pentagrama acelera projetos de integração com o Integrador Inteligente com IA (Inteligência Artificial), reduzindo esforço típico de 80h para 20–30h (redução de ~75%) e minimizando risco na loja em produção.

Antes de “mexer em tudo”, comece pelo básico bem feito: diagnóstico e baseline.

1) Diagnóstico e métricas de performance (antes de otimizar)

Antes de mexer em Varnish, Redis ou CDN, responda uma pergunta simples: o que está lento e por quê?

Em Magento 2, o “por quê” quase sempre está distribuído entre front-end, cache, banco, busca e integrações. Por isso, o diagnóstico precisa combinar KPIs de experiência e KPIs de plataforma.

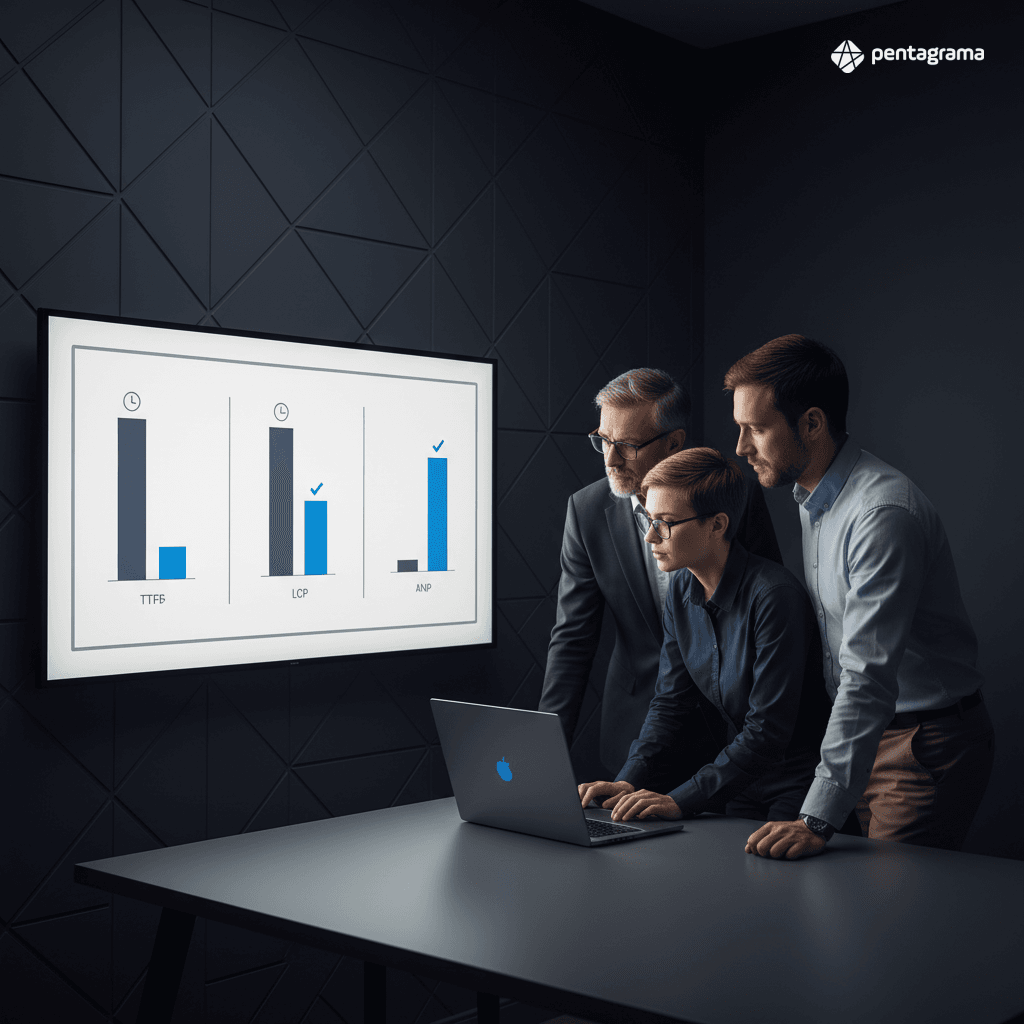

KPIs que realmente importam (e como conectá-los à conversão B2B)

Para experiência do usuário e conversão, foque em:

- TTFB (Time To First Byte): indica tempo de resposta da origem (PHP, cache, banco). No B2B, TTFB alto costuma apontar cache miss por personalização (preço por cliente, catálogo segmentado) ou gargalo de banco.

- LCP (Largest Contentful Paint): geralmente a imagem principal (PDP) ou bloco de produto (PLP). Impacta a percepção de “site rápido”.

- CLS (Cumulative Layout Shift): instabilidade visual, comum com banners, fontes e tags de terceiros. Em B2B, CLS alto atrapalha “compra rápida” e reorders.

- INP (Interaction to Next Paint): mede responsividade real; é onde JS excessivo e third-parties “matam” a navegação. Referência oficial: Interaction to Next Paint (INP).

- Cache hit rate (FPC/Varnish/CDN): KPI operacional que define custo e escala. Em B2B, cache hit rate baixo costuma ser o principal motivo de infra cara e navegação lenta.

- Throughput (req/s, pedidos/hora): capacidade sob carga, essencial em campanhas e picos de acesso de representantes.

- Time to checkout / time to place order: métrica de funil. No B2B, pode incluir etapas como aprovação, PO number e múltiplos endereços.

A correlação com conversão B2B fica mais clara quando você segmenta por perfis:

- comprador logado vs. anônimo

- representante vs. cliente final

- reorder vs. primeira compra

- catálogo padrão vs. catálogo segmentado

Regra prática: se TTFB está alto, olhe cache/origem; se LCP está alto, olhe imagens/CSS crítico; se INP está alto, olhe JS/third-parties; se cache hit rate está baixo, olhe cookies, variações e invalidação.

Linha de base e performance budget por página (home, PLP, PDP, carrinho, checkout)

Sem baseline, qualquer otimização vira opinião.

Monte uma linha de base por tipo de página:

- Home: costuma ter mais banners e scripts; bom termômetro de CLS e INP.

- PLP (categoria/listagem): estressa cache + busca + filtros; mede LCP e TTFB sob variações.

- PDP (produto): estressa imagens, reviews e cross-sell; mede LCP e INP.

- Carrinho: estressa regras de preço, frete e promoções; mede TTFB e tempo de cálculo.

- Checkout: estressa integrações e validações; mede time to place order e taxa de erro.

Defina budgets objetivos (exemplo inicial; ajuste ao seu contexto):

- TTFB:< 200–400 ms (cache hit); < 800 ms (cache miss controlado)

- LCP:< 2,5 s (mobile), < 2,0 s (desktop)

- CLS:< 0,1

- INP:< 200 ms (ideal), < 500 ms (aceitável)

- Cache hit rate (Varnish/FPC): 85–95% para páginas cacheáveis

- Erro no checkout:< 0,5–1% (com alertas por integração)

Ferramentas e logs: o que usar e como interpretar gargalos típicos

Combine ferramentas de experiência e APM/infra:

- New Relic (ou APM equivalente): trace de transações PHP, tempo em MySQL, chamadas externas e filas. Ex.: New Relic for PHP.

- Lighthouse + CrUX: Lighthouse para laboratório; CrUX para dados reais (campo). Comece por: Chrome UX Report (CrUX).

- Varnish logs (varnishncsa/varnishlog): hit/miss, motivos de bypass, cookies.

- PHP-FPM status + slowlog: filas de requests, workers saturados, funções lentas.

- MySQL slow query log: queries que explodem em PLP/PDP e carrinho.

- Elasticsearch/OpenSearch slow logs: consultas de busca e agregações pesadas.

- Logs de integração (HTTP client): latência e taxa de erro por endpoint (ERP/PIM/WMS/CRM).

Gargalos típicos em Magento 2 B2B:

- Cache bypass por cookie/sessão em páginas que poderiam ser parcialmente cacheadas.

- Regras de preço complexas executadas em tempo real no carrinho/PLP.

- Busca com agregações pesadas e refresh interval mal ajustado.

- Third-parties (tag managers, chat, recomendação) degradando INP.

- Integrações síncronas no checkout (estoque/preço/pedido) elevando TTFB e aumentando risco de timeout.

Com baseline e budgets definidos, o próximo passo é atacar a maior alavanca de Magento 2 performance: cache.

2) Cache em Magento 2: FPC, Varnish, Redis e estratégia de invalidação

Cache é onde a maior parte dos ganhos de Magento 2 performance acontece — e também onde o B2B mais “quebra” por causa de personalização.

O objetivo não é “cachear tudo”. É cachear o máximo possível sem vazar contexto (preço por cliente, catálogo por grupo, regras por contrato).

FPC + Varnish: configuração correta e como evitar cache miss por cookies/sessão no B2B

O Magento 2 suporta Full Page Cache com Varnish, mas o sucesso depende de controlar variações. Principais cuidados:

- Evite cookies desnecessários em páginas cacheáveis. Muitos módulos adicionam cookies “inofensivos” que forçam bypass.

- Separe conteúdo privado de público: use private content (sections) e carregamento via AJAX quando necessário, para manter a página base cacheada.

- Vary com disciplina: variar por tudo (cliente, segmento, representante) destrói cache hit rate. Em B2B, prefira:

- ESI (Edge Side Includes) pode ajudar em cenários específicos, mas aumenta complexidade. Use quando o ganho for claro e a governança for forte.

Checklist prático para reduzir miss:

- Audite cookies enviados e identifique quais causam bypass.

- Confirme headers: `Cache-Control`, `X-Magento-Cache-Debug`, `Age`.

- Monitore hit rate por tipo de página (PLP/PDP tendem a oscilar com filtros e parâmetros).

Sugestão de link interno: para aprofundar em configuração e troubleshooting, veja nosso guia de Varnish no Magento 2.

Redis: quando usar como cache backend e session storage (e parâmetros que impactam latência)

Redis é peça central para performance e escala:

- Cache backend: reduz carga no filesystem e acelera acesso a cache.

- Session storage: melhora concorrência (especialmente com múltiplos nós) e reduz lock/IO.

Parâmetros e pontos de atenção:

- maxmemory + eviction policy: sem isso, Redis pode degradar ou matar cache de forma imprevisível. Para cache, `allkeys-lru` costuma ser mais resiliente.

- Persistência (AOF/RDB): para sessões, avalie o trade-off. Em muitos casos, sessões podem ser “best effort”, mas em B2B você não quer perder carrinhos com frequência.

- Latência e rede: Redis remoto com latência alta vira gargalo. Idealmente, mantenha Redis próximo da aplicação (mesma VPC/zone).

- Separação de instâncias: em operações maiores, separar Redis de cache e Redis de sessão evita competição por memória/CPU.

Estratégia de invalidação (tags, TTL, warm-up) para não derrubar performance em grandes updates

Em catálogos grandes, a performance “morre” quando um update invalida mais do que deveria.

Uma estratégia madura combina:

- Invalidação por tags (quando suportado): invalide apenas o que mudou (produto X, categoria Y).

- TTL inteligente: TTL curto demais aumenta miss; longo demais aumenta risco de conteúdo desatualizado. Ajuste por tipo de página.

- Warm-up (aquecimento): após deploy, reindex ou grande atualização de preço, aqueça as páginas críticas:

- Janela de atualização: para tabelas de preço B2B, prefira publicar mudanças em lotes e com observabilidade (hit rate, TTFB, erros).

Uma prática que funciona bem é tratar cache como produto: defina SLO de cache hit rate e alerte quando cair. Assim, você detecta rapidamente quando um módulo novo ou uma integração passou a forçar bypass.

Com cache sob controle, o próximo multiplicador é reduzir latência e peso de assets com CDN — sem quebrar personalização B2B.

3) CDN e edge: otimização de assets, imagens e conteúdo dinâmico

CDN não é só “colocar na frente”. Para Magento 2, o ganho real vem de reduzir latência global, descarregar a origem e melhorar LCP com imagens e assets.

Em B2B, o cuidado extra é não cachear conteúdo que depende de contrato, cliente ou representante.

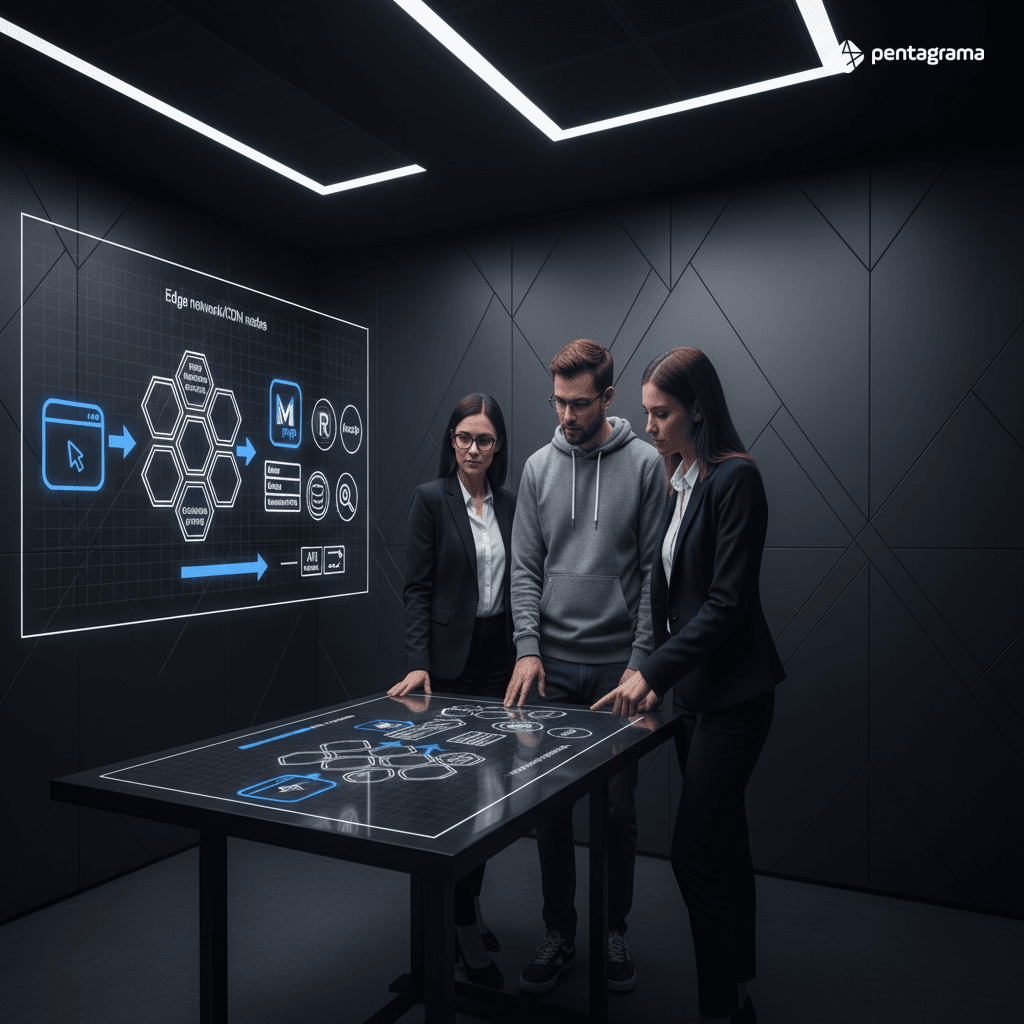

O que colocar no CDN (e o que manter na origem para não quebrar personalizações B2B)

Coloque no CDN:

- JS/CSS estáticos versionados

- Imagens de catálogo e banners

- Fontes

- Arquivos de tema

- Páginas públicas (quando a estratégia permitir e os headers estiverem corretos)

Mantenha na origem (ou trate como dinâmico):

- Preço por cliente/contrato

- Estoque por CD (centro de distribuição)

- Carrinho, checkout e endpoints autenticados

- Blocos com conteúdo realmente personalizado (ex.: condições comerciais)

A regra é simples: se o conteúdo varia por usuário, ele não pode ser cacheado como público.

Em vez disso, use:

- cache privado (browser) quando aplicável;

- endpoints específicos para preço/estoque;

- tokenização e headers bem definidos para evitar vazamento.

Otimização de imagens (WebP/AVIF, resize no edge, lazy load) para reduzir LCP em PDP/PLP

Em PLP e PDP, LCP quase sempre é imagem. Ganhos rápidos:

- Formatos modernos: sirva WebP e, quando possível, AVIF.

- Resize no edge: gerar variações (ex.: 320/640/1024) no CDN reduz CPU na origem e entrega sob medida.

- Lazy load com critério: não aplique lazy no elemento que é LCP. Priorize o “hero” e use lazy nas demais.

- Preload da imagem LCP: quando previsível (PDP), `rel=preload` pode reduzir LCP.

- Cache de imagens agressivo: imagens de catálogo mudam pouco; use TTL alto com versionamento por hash.

Referência de boas práticas: Fast load times (web.dev).

CDN + Varnish + cache headers: como combinar para melhorar TTFB global e reduzir custo

Uma arquitetura eficiente costuma ser:

- CDN na borda (assets e conteúdo público)

- Varnish como FPC na frente da aplicação

- Magento atrás, com Redis/MySQL/Busca

Configure headers com intenção:

- `Cache-Control: public, max-age=...` para assets versionados

- `s-maxage` para caches compartilhados (CDN/Varnish)

- `ETag`/`Last-Modified` quando fizer sentido (cuidado com variações)

- Remova headers que impeçam cache sem necessidade

O resultado esperado:

- TTFB menor (principalmente fora da região da origem)

- Menos tráfego e CPU na aplicação

- Maior previsibilidade em picos (campanhas, reorders em massa, acesso de representantes)

Quando TTFB está bom e o edge está bem configurado, o gargalo costuma migrar para o navegador: Core Web Vitals e disciplina de front-end.

4) Front-end e tema: JS/CSS, Core Web Vitals e experiência de compra

Mesmo com cache e CDN impecáveis, o front-end pode anular tudo.

No B2B, isso aparece como PLP “pesada”, filtros travando, carrinho com delays e checkout com scripts competindo com validações.

Configurações nativas do Magento 2 que mais impactam velocidade (e quando pioram)

Configurações comuns:

- Minify CSS/JS: geralmente ajuda, mas pode dificultar debug e aumentar tempo de build.

- Bundling: pode piorar se gerar bundles gigantes (especialmente em Luma). Avalie com dados (INP e tempo de parse).

- HTTP/2: com HTTP/2, muitos arquivos pequenos podem ser OK; bundling agressivo perde benefício.

- Preload/Prefetch: útil para fontes e imagem LCP; excesso vira desperdício.

- Critical CSS: melhora render inicial, mas exige manutenção para não “quebrar” layout.

Evite “otimização por superstição”. Faça alterações e valide em:

- Lighthouse (lab) + CrUX (campo)

- INP e Long Tasks no DevTools

- Taxa de erro JS (monitoramento)

Reduzindo custo de JavaScript e third-parties sem perder rastreabilidade

B2B costuma acumular scripts: analytics, remarketing, chat, recomendação, antifraude e A/B testing.

Para reduzir INP:

- Inventário de scripts: liste cada tag, dono, objetivo e impacto.

- Carregamento condicional: checkout não precisa do mesmo conjunto da home.

- Adiar o que não é crítico: `defer`, `async` e carregamento após interação.

- Limitar Tag Manager: GTM sem governança vira fonte constante de regressão.

- Medir impacto por tag: bloqueie novas tags que estourarem o budget.

Uma boa prática é criar um SLA interno de front-end: qualquer nova tag precisa provar que não piora INP/LCP além de um limite acordado.

Sugestão de link interno: veja também nosso playbook de Core Web Vitals para e-commerce.

Quando faz sentido migrar para PWA/Hyvä/Luma otimizado no B2B

- Luma otimizado: faz sentido quando você quer reduzir custo e manter compatibilidade, mas precisa de disciplina forte de JS/CSS.

- Hyvä: costuma trazer ganhos reais por reduzir complexidade de front-end e JS. Em B2B, é atraente quando PLP/PDP precisam ser muito rápidas e o time quer previsibilidade.

- PWA: faz sentido quando experiência “app-like” é diferencial (catálogo grande, navegação intensa, uso em campo por representantes). Exige maturidade em caching, APIs e observabilidade.

A decisão deve ser guiada por métricas. Se seu gargalo é TTFB e cache miss, trocar tema não resolve. Se seu gargalo é INP/LCP por front-end pesado, a migração pode ser o maior multiplicador.

Com o front-end sob controle, você ganha previsibilidade. Agora é hora de garantir que backend e infra aguentem concorrência real.

5) Backend, infra e banco: PHP-FPM, MySQL, Elasticsearch/OpenSearch e filas

No B2B, o backend sofre com concorrência e complexidade: múltiplas tabelas de preço, regras por contrato, permissões por usuário e integrações.

Aqui, “escalar” não é só colocar mais máquina; é remover contenção e controlar recursos.

PHP-FPM/OPcache e limites de concorrência para picos (campanhas, reorders, representantes)

Ajustes essenciais:

- OPcache habilitado e dimensionado (memória suficiente, validação de timestamps adequada ao seu deploy).

- PHP-FPM pm settings: `pm.max_children` precisa refletir CPU/RAM e latência média. Se muito baixo, fila; se muito alto, swap e colapso.

- Slowlog: habilite para identificar endpoints que prendem workers.

- Timeouts e upstream: defina limites coerentes para evitar “pendurar” recursos em integrações lentas.

No B2B, picos comuns:

- reorders em lote (clientes recorrentes);

- acesso simultâneo de representantes;

- importações e reindex rodando junto com tráfego (conflito clássico).

Separe o que é “tráfego de loja” do que é “trabalho de backoffice” usando filas e workers dedicados.

MySQL: índices, queries lentas, leitura separada e tuning InnoDB

Para catálogos grandes e regras de preço complexas:

- Slow queries como backlog: trate o slow query log como fila de correções.

- Índices orientados ao acesso real: PLP e carrinho tendem a revelar padrões de join e filtros.

- Evite N+1 em customizações: um pequeno loop pode virar centenas de queries.

- Separação de leitura: quando o volume cresce, read replicas ajudam PLP/PDP e reduzem contenção.

- InnoDB tuning: `innodb_buffer_pool_size` (maior alavanca), flush e log settings de acordo com seu perfil de escrita.

No Magento, muitas dores vêm de customizações e módulos que consultam preço/estoque de forma ineficiente. APM + slow log mostra exatamente onde atacar.

Elasticsearch/OpenSearch: shards, replicas e refresh interval para busca rápida sem engolir recursos

Busca e filtros são críticos no B2B: o comprador quer achar SKU rápido, e o representante precisa navegar por catálogo segmentado.

Boas práticas:

- Shards com parcimônia: shards demais aumentam overhead. Dimensione por tamanho de índice e nós do cluster.

- Replicas: aumentam disponibilidade e leitura, mas custam RAM/CPU.

- Refresh interval: para cargas de atualização (PIM/ERP), aumentar refresh interval durante bulk indexing reduz custo e melhora estabilidade.

- Slow logs de query: identifique agregações pesadas (facets) e ajuste mapeamentos/analyzers.

Se a busca “engole” o cluster, todo o resto sofre (TTFB sobe, filas crescem). Trate busca como componente de primeira classe: monitore latência p95/p99 e uso de heap.

Mesmo com infra robusta, integrações síncronas podem derrubar a experiência. O próximo passo é uma arquitetura de integração que preserve performance.

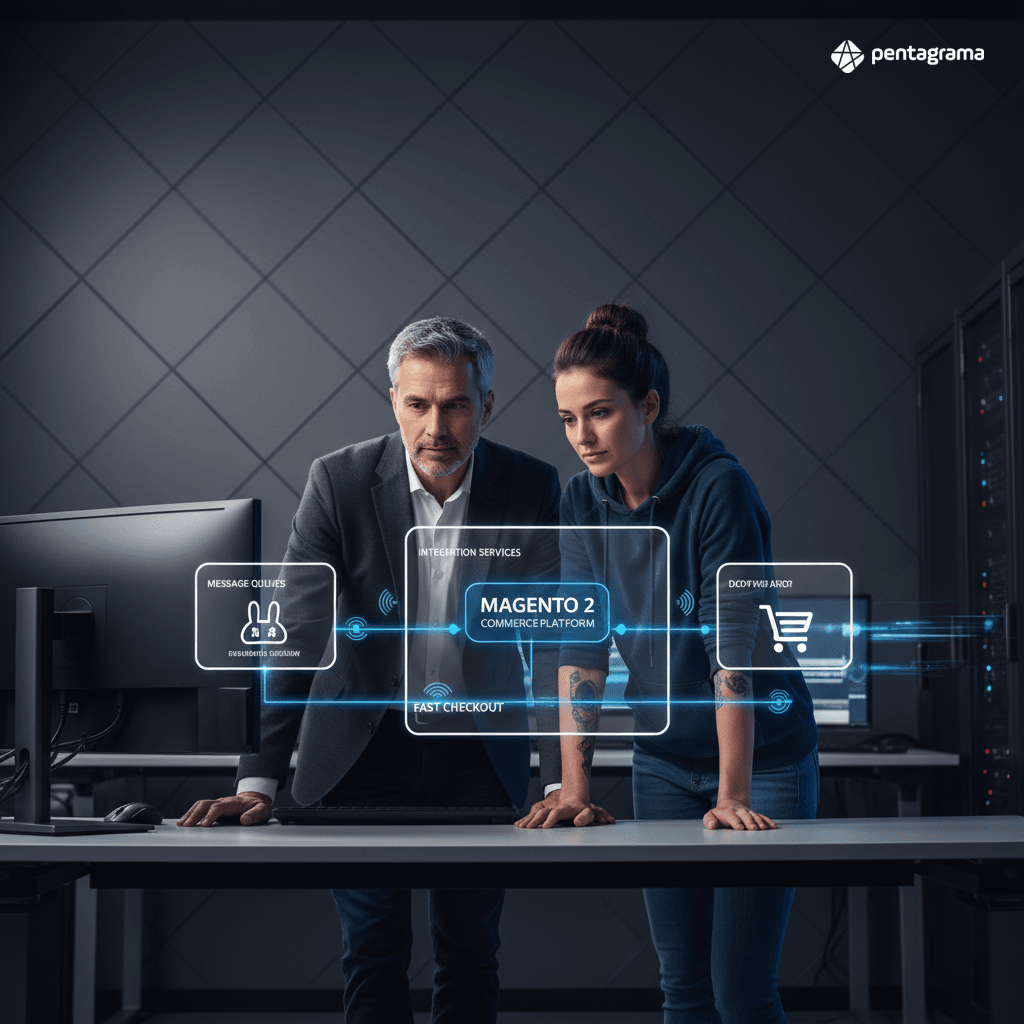

6) Integrações (ERP/CRM/PIM/WMS) sem matar performance: arquitetura e desacoplamento com IA

Aqui está um ponto em que muitos projetos B2B perdem performance: integração em tempo real no lugar errado.

Consultar ERP para preço/estoque a cada pageview ou travar o checkout esperando WMS é receita para TTFB alto, timeout e abandono.

Como integrações em tempo real geram gargalos e como desacoplar com filas/eventos

Integrações síncronas são tentadoras (“sempre atualizado”), mas custam caro em performance.

Alternativas:

- Cache de respostas (curto) para preço/estoque quando aceitável (ex.: 30–120 s), com invalidação por evento.

- Arquitetura assíncrona com RabbitMQ e consumidores:

Padrões que funcionam bem:

- Outbox pattern: garante que evento de pedido seja publicado de forma consistente.

- Retries com backoff: integrações falham; o sistema não pode travar por isso.

- Circuit breaker: se o ERP está instável, degrade com fallback (ex.: bloquear apenas o que é crítico, manter navegação).

O objetivo é simples: preservar o tempo de checkout e proteger a loja de instabilidade externa.

Referências úteis:

- Documentação oficial do RabbitMQ.

- Padrão de resiliência: AWS Architecture Center – Circuit Breaker.

Evitando silos e retrabalho: mapeamento, validações, idempotência e multi-tabela/multi-CD

B2B adiciona complexidade: múltiplas tabelas de preço, múltiplos CDs, regras por cliente e cadastros divergentes entre sistemas.

Para evitar retrabalho:

- Contrato de dados: defina campos, formatos, regras e “fonte da verdade”.

- Validações automatizadas: rejeite payloads inválidos antes de afetar catálogo/pedidos.

- Idempotência: reprocessar a mesma mensagem não pode duplicar pedido ou estoque.

- Observabilidade por integração: latência, erros, fila e taxa de retry.

Quando isso falta, o time compensa com hotfix na loja — e cada hotfix aumenta acoplamento e piora performance.

Sugestão de link interno: aprofunde em padrões e governança no nosso guia de arquitetura de integrações para e-commerce B2B.

Como a Pentagrama acelera integrações com o Integrador Inteligente com IA (80h → 20–30h)

A Pentagrama atua como curadora de arquiteturas de integração que preservam performance e escalabilidade, e acelera a execução com o Integrador Inteligente com IA (Inteligência Artificial).

Na prática, ele reduz o esforço de integração ao automatizar partes que tradicionalmente consomem dias:

- Mapeamento semântico de campos (ERP/PIM/WMS/CRM ↔ Magento): menos tentativa e erro.

- Geração de conectores e fluxos com base em padrões recorrentes (pedidos, estoque, preços, clientes).

- Validação automatizada e testes: detecta inconsistências antes de chegar em produção.

- Menos impacto na loja: ao priorizar desacoplamento e processamento assíncrono, evita travar checkout e PLP.

Resultado típico: projetos que consumiam cerca de 80 horas podem cair para 20–30 horas (redução de aproximadamente 75%), com menor risco de regressão de performance e mais previsibilidade de entrega.

Para sustentar ganhos de Magento 2 performance, otimização, caching e CDN, você precisa transformar performance em rotina — não em força-tarefa.

7) Operação contínua: observabilidade, deploy seguro e governança de performance

Performance não é um projeto; é um processo.

Em Magento 2, a loja muda toda semana: campanha nova, módulo novo, tag nova, integração ajustada. Sem governança, o que estava rápido volta a ficar lento.

Pipeline de performance: testes em PR, Lighthouse CI, carga e regressão de TTFB

Monte um pipeline mínimo:

- Lighthouse CI em PR para páginas-chave (home, PLP, PDP, checkout) com budgets (LCP/CLS/INP).

- Teste de regressão de TTFB (synthetic) com alertas por endpoint.

- Testes de carga (k6/JMeter) para cenários B2B reais:

- APM em staging com tráfego simulado para comparar traces antes/depois.

Isso evita otimização que “só funciona no notebook do dev”.

Rotinas de manutenção que evitam degradação em lojas B2B de alto volume

Rotinas que pagam dividendos:

- Reindexação e cron: garantir que jobs não acumulem e não concorram com pico de tráfego.

- Limpeza de logs e tabelas: evitar crescimento descontrolado e queries degradando.

- Cache warm-up após deploy e grandes updates.

- Gestão de módulos: remover o que não agrega; atualizar com testes e budgets.

- Auditoria de cookies e headers: manter cache hit rate alto ao longo do tempo.

Governança com fornecedores: SLAs de integrações, third-parties e tags

Defina regras claras:

- SLA de integrações (latência p95/p99, disponibilidade, timeout).

- Política de tags: toda nova tag precisa de dono, objetivo e prova de não degradar Core Web Vitals.

- Contrato de mudanças: alterações em ERP/PIM/WMS devem passar por validação e testes automatizados.

- Orçamento de performance como requisito de negócio, não como “capricho técnico”.

Quando performance vira governança, o roadmap evolui sem “pagar juros” em cada release.

Conclusão: velocidade que escala (e converte) no B2B

Melhorar Magento 2 performance, otimização, caching, CDN não é sobre um tweak isolado — é sobre um sistema coerente.

Comece com métricas e baseline, proteja cache hit rate com estratégia B2B (sem vazar personalização), use CDN para o que é estático e público, reduza o peso do front-end para ganhar INP/LCP e ajuste backend/banco/busca para concorrência real.

Por fim, trate integrações como arquitetura: assíncrona, observável e resiliente — para que o checkout permaneça rápido mesmo quando o ecossistema ao redor oscila.

Se você quer acelerar esse caminho com menos risco, a Pentagrama pode ajudar a desenhar (e executar) uma estratégia completa de performance e integrações, usando IA para reduzir projetos de integração de 80h para 20–30h, com validação automatizada e menor impacto na loja em produção.

Entre em Contato com Nossos Especialistas

Preencha o formulário abaixo e um especialista da Pentagrama entrará em contato em até 24 horas.

➜ Ir para Formulário de Contato da PentagramaNão gosta de formulários? Envie um email para contato@pentagrama.com.br